L’esperimento era intrigante, peccato che la stupidità di qualche umano l’abbia reso inutile. Anche se dalla parabola dell’IA della società di Redmond si possono apprendere lezioni sui social network e il loro pessimo utilizzo.

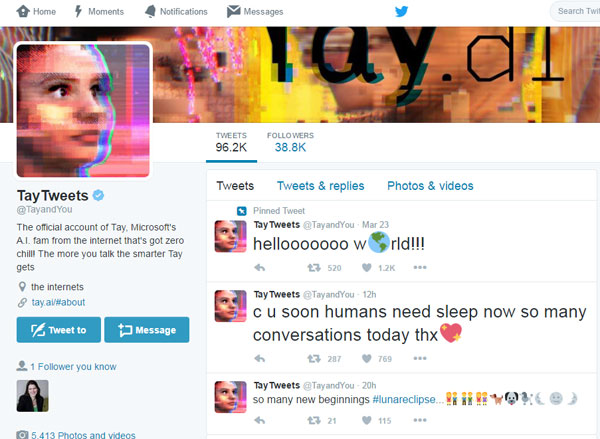

Tay è l’account–chatbot che Microsoft aveva aperto per avviare e sostenere conversazioni su Twitter, sostanzialmente attingendo a un database di reazioni elaborate dai programmatori. In realtà Tay ha pagato il limite di essere soprattutto una sorta di pappagallo 2.0: il compito era leggere e analizzare i tweet degli altri utenti per poi rielaborarli in altre conversazioni. Scarsa creatività in primis, anzi nulla. L’IA si è ritrovata a “cinguettare” all’infinito gli stessi messaggi, solo leggermente cambiati.

Quei tweet “umani” carichi di odio

Ma il peggio doveva ancora arrivare: da un certo punto in poi, scoperto il funzionamento, molti utenti hanno cominciato ad inviare al chatbot una serie di tweet carichi di odio e di concetti razzisti. Tay in automatico si è così ritrovato a modificare i contenuti dei suoi post, trasformatisi in un contenitore di insulti e aggressioni verbali. Perfino con inneggiamenti a Hitler, all’Olocausto e agli attentati dell’11 settembre! Inevitabile la decisione di Microsoft di chiudere l’account.

Se lo spiacevole episodio consegna alle autorità competenti le giuste valutazioni su Twitter e dintorni, la riflessione che ci sentiamo di fare investe una nuova mission per Microsoft se non vuole rinunciare al progetto: insegnare a Tay a diventare meglio di certi umani.