Robot umanoidi controllati dall’uomo semplicemente attraverso il pensiero. Uno scenario da fantascienza che comincia a diventare realtà al Mit (Massachusetts Institute of Technology) di Boston, grazie allo sviluppo di un’interfaccia computerizzata che rende possibile tutto ciò. Una via innovativa che i ricercatori del prestigioso istituto americano, in collaborazione con i colleghi dell’Università di Boston, hanno deciso di battere con l’obiettivo di sviluppare una maggiore e più efficiente interazione tra uomo e robot.

Affinché un robot possa eseguire un preciso compito ha bisogno infatti di comprendere ciò che gli viene richiesto. Le vie per farlo finora a disposizione sono state due: insegnare ai robot il linguaggio umano, compito abbastanza difficile e molto lungo, per via della complessità intrinseca del linguaggio umano, oppure dare loro dei comandi espliciti.

Il gruppo di ricercatori, guidato dalla dottoressa Daniela Rus, direttrice del Computer science and artificial intelligence laboratory (Csail), ha invece deciso di affrontare il problema con un nuovo approccio puntando a fare del robot una sorta di protesi dell’uomo, capace di eseguire i comandi che il controllore umano sta pensando. Un progetto raccontato in uno studio che sarà presentato all’International conference on robotics and automation (Icra) in programma a maggio a Singapore.

L’interfaccia che legge il pensiero

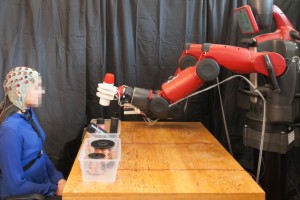

Fulcro del lavoro è un’interfaccia computerizzata basata su un casco collegato a un elettroencefalogramma (Ecg) che monitora l’attività cerebrale. Più nello specifico i segnali cerebrali considerati sono i cosiddetti errori-correlati potenziali (ErrPs), che si generano quando il nostro cervello nota un errore. Seppur molto deboli, i ricercatori sono riusciti a integrarli in un algoritmo che il robot può leggere e interpretare per comprendere se l’uomo è d’accordo o meno con la sua decisione, il tutto in un intervallo di tempo che va da 10 a 30 millisecondi, come viene mostrato in questo video.

Il sistema, testato sul robot umanoide Baxter, fornito da Rethink Robotics, al momento permette solo di impartire al robot comandi binari semplici, come scegliere tra due oggetti differenti, con una precisione del 65% che i ricercatori contano di portare in breve tempo a livelli superiori al 90%.

Per rendere il tutto ancora più accurato, i ricercatori hanno cercato di rilevare anche gli errori secondari, che si hanno quando il sistema non nota la correzione umana originale, ma ancora con scarsi risultati. Se il robot non è sicuro della sua decisione, può stimolare la risposta dell’uomo per avere un riscontro più accurato.

Un’interazione più naturale

Ma l’importanza del progetto sta soprattutto nell’introduzione di un elemento di semplificazione notevole rispetto ad altri approcci similari. A differenza di studi passati, dove alle persone veniva insegnato a pensare in modo riconoscibile dal computer, cosa che richiede tra l’altro un grande sforzo di concentrazione, in questo caso tutto è molto più semplice e naturale. «Tutto quello che occorre fare è essere mentalmente in accordo o in disaccordo con quanto la macchina sta per fare – ha infatti spiegato Rus -. Non c’è alcun bisogno di allenarsi a pensare in un certo modo, è il robot che si adatta a te, e non il contrario».

Un passo in avanti fondamentale, che potrà avere sviluppi enormi in diverse applicazioni, dal campo industriale, con la possibilità di gestire robot attivi nella produzione, a quello medicale, per controllare con il pensiero protesi robotiche, fino ad arrivare ai veicoli a guida autonoma, consentendo di effettuare correzioni al comportamento della vettura nel caso in cui si notassero degli errori.