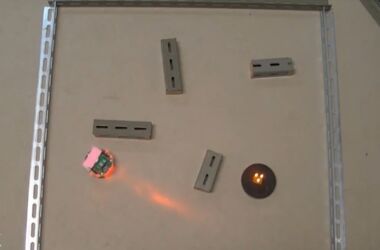

Il team di ricerca di Facebook specializzato in Intelligenza Artificiale ha sviluppato un assistente robotico domestico che può muoversi in un ambiente non mappato e in grado di rispondere a compiti che richiedono il rilevamento sia visivo che uditivo, come “prendi il mio telefono che squilla”. La novità è stata comunicata attraverso uno specifico post nel blog del social network.

Gli assistenti virtuali come li conosciamo – sottolinea il post – non sono capaci di identificare un suono specifico, usarlo come bersaglio e navigare attraverso lo spazio se non gli viene detto esattamente dove andare. “Per svolgere un’attività come controllare per vedere se hai chiuso a chiave la porta principale o se stai recuperando un cellulare che squilla in una camera da letto al piano di sopra, gli assistenti IA del futuro devono imparare a pianificare il loro percorso, navigare in modo efficace, guardarsi intorno nel loro ambiente fisico, ascoltare quello che sta succedendo intorno a loro e costruire ricordi dello spazio 3D”, scrivono gli autori del post, e ricercatori di Facebook, Kristen Grauman e Dhruv Batra.

Per ovviare a questa lacuna il team ha sviluppato “SoundSpaces”, la prima piattaforma open source audiovisiva capaci di analizzare i suoni ambientali, progettata per la creazione di modelli di Intelligenza Artificiale “incorporata” più performante e in grado di aiutare i robot a orientarsi in modo più efficiente. L’audio è importante per la navigazione perché aggiunge contesto ai dati visivi che un robot raccoglie con le sue telecamere.

“SoundSpaces” fornisce una raccolta di file audio che gli sviluppatori possono utilizzare per addestrare modelli di Intelligenza Artificiale sensibili al suono in una simulazione. Utilizza un algoritmo all’avanguardia per la modellazione dell’acustica della stanza e un “algoritmo di tracciamento del percorso bidirezionale” per modellare i riflessi del suono nella geometria della stanza.

“Per quanto ne sappiamo, questo è il primo tentativo di addestrare agenti di apprendimento per rinforzo profondo che vedono e sentono per mappare ambienti nuovi e localizzare obiettivi che emettono suoni“, hanno affermato Grauman e Batra.

Questi assistenti più “intelligenti” per poter eseguire i loro compiti richiederanno nuovi progressi dell’IA incorporata e l’obiettivo è quello di insegnare alle macchine a comprendere e interagire con le complessità del mondo fisico così come fanno le persone. Invece di utilizzare set di dati statici, come avviene nella maggior parte dei metodi di intelligenza artificiale tradizionali, l’IA incorporata favorisce un approccio che sfrutta l’apprendimento per rinforzo, in cui i robot imparano attraverso le loro interazioni con la realtà.