Il video che tra poco vi mosteremo racconta brevemente dell’ultima interessante scoperta nel campo delle potenziali relazioni uomo-macchina.

Nella speciale divisione di ricerca Stochastic Labs della celebre Università di Berkeley è stato infatti sviluppato un robot capace di decidere con consapevolezza se “fare del male” a un umano. Anche semplicemente procurargli una leggera ferita come vedremo nel filmato.

Il suo creatore è il robotics developer Alexander Reben. Quest’ultimo è partito dal concetto di base “meglio prevenire che curare”, in definitiva, dal momento che secondo i dati in suo possesso le persone hanno paura dei robot perché immaginano che essi possano anche essere pericolosi, e non vedono sviluppate soluzioni per far si che questo non accada (pure riconoscendo, in prevalenza, che lo sviluppo dell’automazione è importante per la società).

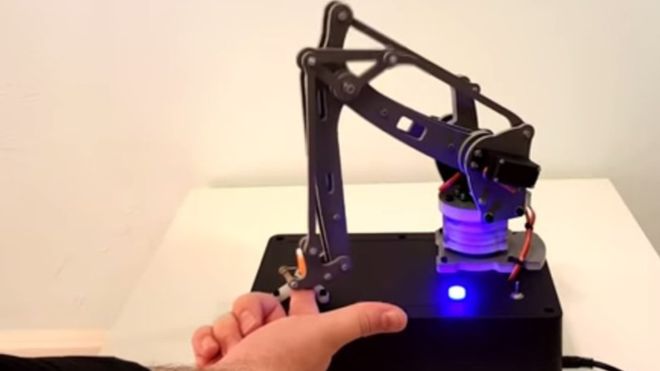

Reben ha denominato il suo robot First Law, con un riferimento alle leggi di Isaac Asimov che tra i primi pose la questione dei rapporti tra uomo e androidi. In questo video vediamo First Law, dal formato di una black box con bracico meccanico, volutamente irretito dal suo inventore

Se il robot viola la prima legge di Asimov… conviene prevenire!

Nel filmato First Law ha dunque “deciso” di “far male” (in modo blando) al proprietario del dito, provocandogli un leggero taglio. Violando però la prima delle leggi di Asimov, quella che recita “un robot non può recar danno a un essere umano né può permettere che, a causa del proprio mancato intervento, un essere umano riceva danno“.

Ma la scelta del robot è assolutamente casuale e non può certo essere comparata con i meccanismi che mettiamo in atto noi umani in tema di decisioni. Il punto è che le conclusioni di Asimov, pure avendo ancora oggi un valore pionieristico straordinario, devono essere per forza rivisitate in chiave moderna, come ha spiegato Reben: “Non esiste in circolazione un androide nato intenzionalmente per far male o aggredire. Ma non bisogna abbassare la guardia con ricerca e sperimentazione proprio per prevenire dei casi di potenziale pericolo”.

Le sue conclusioni fanno idealmente il paio, in questo preciso momento storico, con la decisione di Google di sviluppare una forma di controllo sui robot potenzialmente “ribelli”, come vi abbiamo raccontato di recente qui su Robotica.news.